モデル・デプロイメントのバースト可能なインスタンス

データ・サイエンス・モデル・デプロイメントは、トレーニング済機械学習モデルを推論Webエンドポイントにデプロイするためのフルマネージド・サービスです。推論エンドポイントは、予測のリアルタイム消費のためのWebサービスとしてMLモデル・バイナリをホストします。

デプロイメントの作成時に、ユーザーは使用するコンピュート・シェイプとインスタンスの数を決定する必要があります。多くの場合、モデル・デプロイメントに必要なスケールを事前に決定するのは困難です。これは、外部要因に依存するためです。一方の側から、モデルを常に最適なパフォーマンスの推論に使用できるようにし、もう一方の側では、コストを最適化し、必要のないコンピュート作成インスタンスを使用しないようにします。

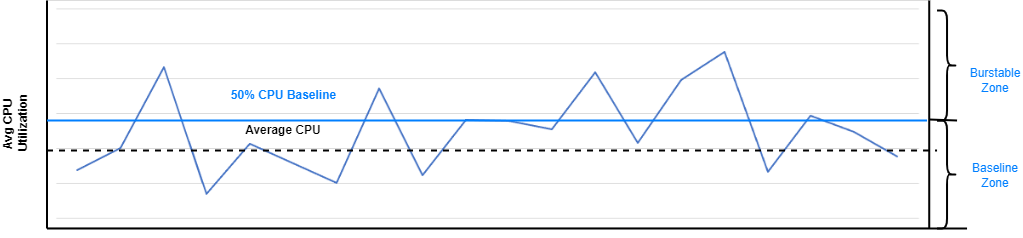

バースト可能なVMのサポートにより、モデルの操作に少量のコンピュートのみが必要で、リクエストの負荷が低い場合に、デプロイメントでVMコアの小数部の使用を有効にして、コンピュートの使用をさらに最適化できます。

主な機能

- 機械学習のバースト可能なインスタンス: 柔軟なCPU使用率を持つ仮想マシンに機械学習モデルをデプロイできます。

- ベースラインCPU使用率: OCIは、さまざまなワークロード需要に適した一般的なCPUベースラインよりも少ない量を提供します。オプションは50%または12.5%であるため、様々なワークロード要求に適しています。機械学習モデルをデプロイする場合、使用可能なベースラインは50%のみです。

- サージ機能: 変化する計算ニーズに適応して、サーバー・リクエストの時折スパイク中に高レベルに急増できます。

- 従来のVMとの比較: CPUリソースが固定された従来のVMインスタンスとは異なり、バースト可能なインスタンスは標準のCPU使用率レベルを維持します。

- ユーザーが選択したベースラインおよびバースティング: ユーザーはベースラインCPU使用率を選択できます。このベースラインを超えるCPU使用率を、プロビジョニングされたCPUコアの最大100%まで一時的に増やすことができます。

請求

バースト可能なインスタンスは、モデル・デプロイメントの作成または更新時に選択されたベースラインOCPUに従って請求されます。バースタブル・インスタンスの料金は、実際のCPU使用率がベースライン上にあるか、ベースラインを下回るか、ベースラインを上回るかに関係なく、同じです。

たとえば、VM.Standard.E4を使用してデプロイメントを作成する場合です。1 OCPUと50%ベースラインを使用するフレックス・インスタンスでは、実際のCPU使用率がOCPUの50%未満であるか、フルOCPUへのバーストであるかに関係なく、1時間ごとに標準E4 OCPUの50%が課金されます。

詳細は、バースト可能なインスタンスのドキュメントを参照してください。

サポートされるシェイプ

バースト可能なモデル・デプロイメントでは、特定のシェイプがサポートされています。

サポートされるシェイプについては、コンピュート・ドキュメントを参照してください。

現在の制限事項

これらは、バースト可能なVMモデル・デプロイメントの制限です。

- 最低6 GBのメモリーでサポートされるベースラインは50%のみで、ベースライン12.5%はサポートされていません。

- バーストは最大1時間の連続バーストに制限されます

- 記憶は破裂しない。

- 基礎となるホストがオーバーサブスクライブされている場合、インスタンスが必要なときに正確にバーストできることは保証されません。